原标题:自动驾驶(二十二)---------贝叶斯公式、极大似然估计

原文来自:CSDN 原文链接:https://blog.csdn.net/zhouyy858/article/details/100097643

自动驾驶中需要对周围车辆、行人行为预测,这就要用到贝叶斯等知识,这里系统的总结和分析一下:

1. 贝叶斯(保守主义的源头)

贝叶斯是机器学习的核心方法之一,所有需要概率预测的地方都可以见到贝叶斯方法的影子。为什么这么重要呢?

现实世界本身的不确定性,由于人类的观察能力是有局限性的,我们日常所观察的只是事物表面上的结果,但是我们想要了解的是这个事物的本质,就需要我们提供一个关于这个事物本质的假设,这个假设本身是不确定的,而且会存在多种假设都能满足条件。那到底那种假设更加符合本质呢?这就需要算出各种不同猜测的可能性,找出最大可能性的一种假设。

例如:一个袋子里有黑球和白球,事先并不知道里面的比例,通过多次闭眼睛摸出一个(或好几个)球,观察这些球的颜色,推测出黑白球的比例。这个问题,就是所谓的逆向概率问题。

贝叶斯公式正是为此如准备的:它是基于假设h、观测的数据D的一个数学公式:

其中:P(h|D)指在数据D的基础上,假设h的发生概率。P(D|h)指给定假设时观测到数据D的概率,P(h)是假设的先验概率,P(D)是数据的先验概率。

我们可以从条件概率的定义推导出贝叶斯定理。根据条件概率的定义,在事件 B 发生的条件下事件 A 发生的概率为:

同样地,在事件 A 发生的条件下事件 B 发生的概率为: 其中

其中  是指交集

是指交集

结合这两个方程式,我们可以得到:

这个引理有时称作概率乘法规则。上式两边同除以 P(A),若P(A)是非零的,我们可以得到贝叶斯定理:

如果对于一个有多个特征的数据集,那么贝叶斯的形式就要写成

在朴素贝叶斯中,我们假设各特征相互独立,所以,最终写成:

。

。

通常,事件 A 在事件 B 发生的条件下的概率,与事件 B 在事件 A 发生的条件下的概率是不一样的;然而,这两者是有确定关系的,贝叶斯定理就是这种关系的陈述。

贝叶斯公式的用途在于通过己知三个概率来推测第四个概率。它的内容是:在 B 出现的前提下,A 出现的概率等于 A 出现的前提下 B 出现的概率乘以 A 出现的概率再除以 B 出现的概率。通过联系 A 与 B,计算从一个事件发生的情况下另一事件发生的概率,即从结果上溯到源头(也即逆向概率)。

通俗地讲就是当你不能确定某一个事件发生的概率时,你可以依靠与该事件本质属性相关的事件发生的概率去推测该事件发生的概率。用数学语言表达就是:支持某项属性的事件发生得愈多,则该事件发生的的可能性就愈大。这个推理过程有时候也叫贝叶斯推理。

2. 极大自然估计

极大似然估计概括就一句话:“谁大像谁”,极大似然估计来自于频率派,认为参数是固定的,我们要做的事情就是根据已经掌握的数据来估计这个参数;贝叶斯估计认为参数也是服从某种概率分布的,已有的数据只是在这种参数的分布下产生的。

所以极大似然估计与贝叶斯估计最大的不同就在于是否考虑了先验,而两者适用范围也变成了:极大似然估计适用于数据大量,估计的参数能够较好的反映实际情况;而贝叶斯估计则在数据量较少或者比较稀疏的情况下,考虑先验来提升准确率。

贝叶斯估计则是将参数视为是有某种已知先验分布的随机变量,这个参数他不是一个固定的未知数,而是符合一定先验分布如:随机变量θ符合正态分布等!那么在贝叶斯估计中除了类条件概率密度p(x|w)符合一定的先验分布,参数θ也符合一定的先验分布。我们通过贝叶斯规则将参数的先验分布转化成后验分布进行求解!

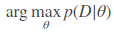

极大似然估计法认为参数是固有的,但是可能由于一些外界噪声的干扰,使数据看起来不是完全由参数决定的。没关系,数学家们觉得,虽然有误差存在,但只要让在这个数据给定的情况下,找到一个概率最大的参数就可以了。那问题其实就变成了一个条件概率最大的求解,即求使得p(θ|D)最大的参数θ,形式化表达为求解

而根据条件概率公式有

因为我们在极大似然估计中假设 θ是确定的,所以p(θ)就是一个常数。p(D) 同样是根据已有的数据得到的,也是确定的,或者我们可以把其看作是对整个概率的一个归一化因子。这时候,求解公式(1) 就变成了求解  的问题了。

的问题了。

p(D|θ) 就是似然函数,我们要做的就是求一个是似然最大的参数,所以称为极大似然估计。 想求解这个问题,需要假设我们的数据是相互独立的。D={x1,x2,x3,...,xn},这时候有 :

一般对(4)式取对数求解对数极大似然,就可以把连乘变成求和,然后求导取极值点就是要求的参数值,不在此赘述。